卷积神经网络是什么

卷积神经网络(CNN)是一种专门用来处理图像数据的深度学习模型,它的设计灵感来源于人类视觉系统的工作原理。简单来说,CNN就像是一个超级聪明的"图像识别专家",能够自动从图片中提取特征并进行分类识别。

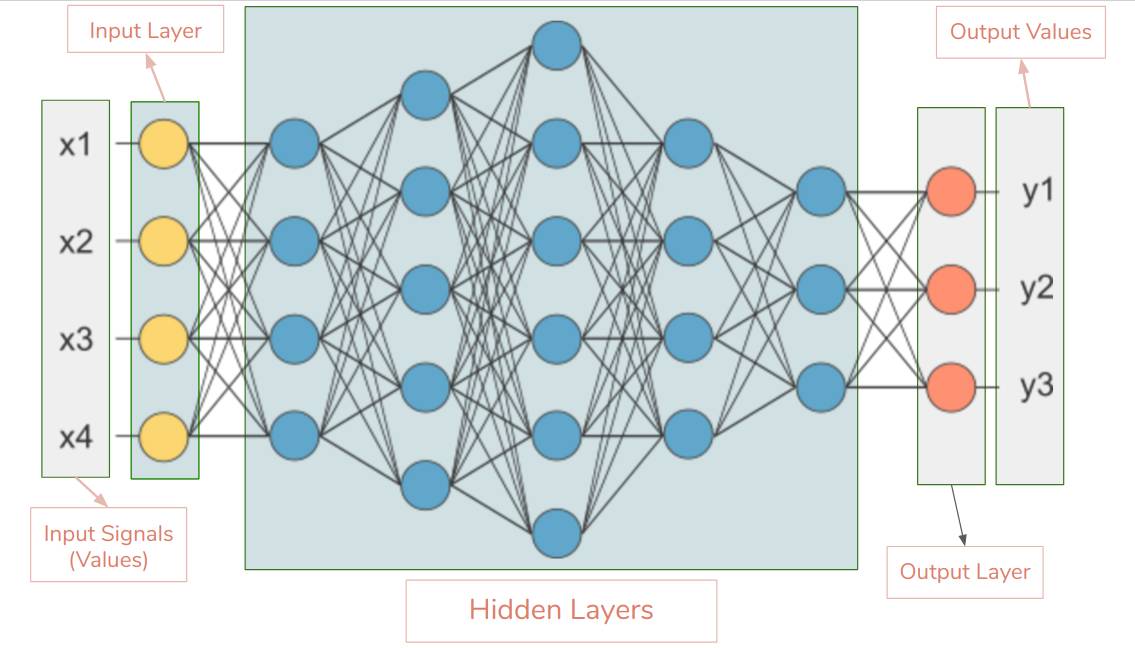

这个模型主要由输入层、卷积层、池化层、全连接层和输出层组成。其中最核心的部分就是卷积层和池化层,它们配合默契,一个负责提取特征,一个负责精简数据,简直就是黄金搭档!

CNN的核心工作原理

-

卷积层的作用机制:卷积操作就像是给图像做"局部体检",通过不同大小的卷积核(滤波器)在图像上滑动,提取出图像的局部特征。这个过程超有意思,就像是用放大镜一寸寸地观察图片的细节,把重要的特征都给找出来。

-

池化层的降维魔法:池化层的主要任务就是降低数据量,防止模型过拟合。它通过取局部区域的最大值或平均值,把特征图缩小,但同时保留了最重要的特征信息。这样一来,计算量大大减少,模型训练速度也快多了!

-

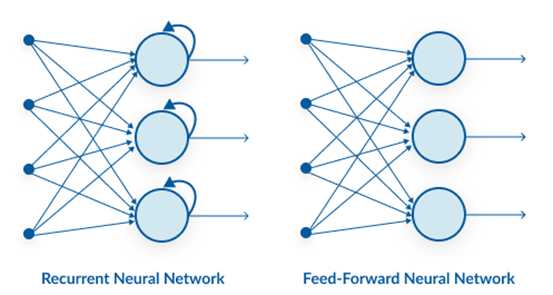

激活函数的非线性处理:为了让网络能够处理复杂的非线性问题,CNN中还会加入激活函数。这些函数给模型注入了"灵魂",让它不再是简单的线性组合,而是能够学习更加复杂的特征模式。

-

全连接层的分类决策:最后,通过全连接层把所有提取到的特征综合起来,输出最终的分类结果。这个过程就像是专家在综合所有证据后做出最终判断,准确率相当高呢!

相关问题解答

- CNN为什么在图像识别领域这么牛?

CNN在图像识别方面表现突出主要是因为它的设计太贴合图像数据的特性了!卷积操作能够有效提取图像的局部特征,而且参数共享机制大大减少了参数量,让训练变得更加高效。再加上池化层的降维作用,整个网络既轻量化又强大,处理起图像来简直得心应手。最重要的是,CNN具有平移不变性,也就是说无论目标物体在图像的哪个位置,它都能准确识别出来,这个特性在实际应用中超级实用!

- 卷积核的大小如何影响模型效果?

卷积核的大小选择可是个技术活!大的卷积核感受野更大,能够捕捉更大范围的特征,但计算量也会增加;小的卷积核则更关注局部细节,计算更高效。在实际应用中,通常采用多层小卷积核叠加的方式来替代大卷积核,这样既能获得足够的感受野,又能减少参数数量,还能增加网络的深度和非线性表达能力。这种设计思路真的很巧妙,既保证了效果又控制了复杂度。

- 池化层在CNN中起什么关键作用?

池化层在CNN中扮演着"数据精简师"的重要角色!它的主要作用有三个:首先是降低特征图的尺寸,大大减少计算量和内存占用;其次是引入平移不变性,让网络对目标位置的变化不那么敏感;最后还能一定程度上防止过拟合。最常见的最大池化就像是选代表,在每个小区域里选最突出的特征来代表整个区域,这样既保留了重要信息又实现了降维,真是一举多得的好设计!

- 如何理解CNN中的参数共享?

参数共享是CNN的一个超级聪明的设计!简单来说,就是同一个卷积核会在整个输入图像上滑动使用,而不是每个位置都用不同的参数。这样做的好处可大了:首先大大减少了需要训练的参数数量,让模型更轻量化;其次让网络具有平移等变性,无论特征出现在图像的哪个位置,都能用同样的方式检测出来;最后还让模型更容易训练和泛化。这种设计理念真的很赞,既高效又实用!

新增评论